A pesar de todas las mejoras en inteligencia artificial, la tecnología aún no puede reemplazar a los seres humanos en situaciones en las que debe marcar sus percepciones del mundo en palabras que las personas pueden entender.

Es posible que haya pensado que los muchos avances aparentes en el reconocimiento de voz ya hayan resuelto el problema. Después de todo, Siri de Apple, Cortana de Microsoft, Alexa de Amazon y Google Home son muy impresionantes, pero estos sistemas funcionan únicamente con la entrada de voz: no pueden entender ni reaccionar ante el entorno que los rodea.

Para cerrar esta brecha de comunicaciones, nuestro equipo de Mitsubishi Electric Research Laboratories ha desarrollado y construido un sistema de inteligencia artificial que hace precisamente eso. Llamamos al sistema de interacción consciente de la escena y planeamos incluirlo en los automóviles.

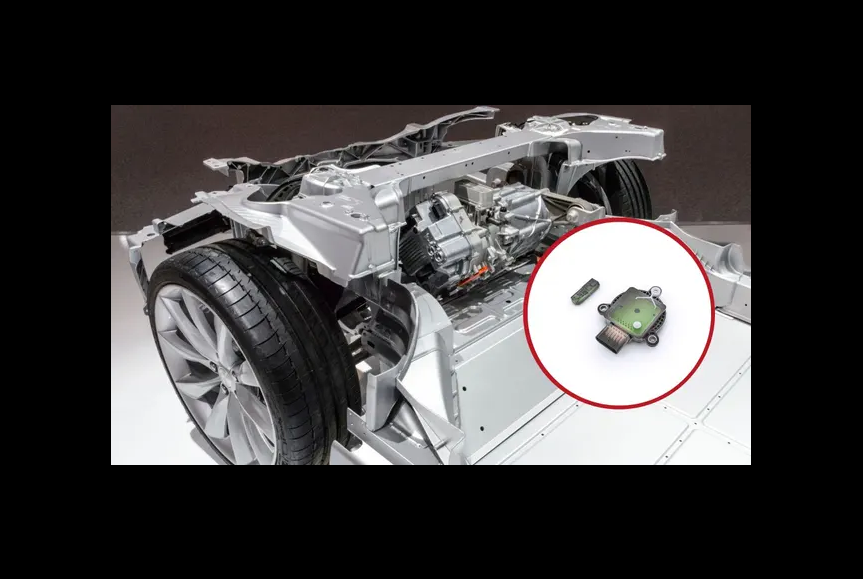

Para respaldar la mejora de la seguridad automotriz y la conducción autónoma, los vehículos están equipados con más sensores que nunca. Las cámaras, el radar de ondas milimétricas y los sensores ultrasónicos se utilizan para el control de crucero automático, el frenado de emergencia, el mantenimiento del carril y la asistencia de estacionamiento. Las cámaras dentro del vehículo también se utilizan para monitorear la salud de los conductores. Pero más allá de los pitidos que alertan al conductor de la presencia de un coche en su ángulo muerto o de las vibraciones del volante que avisan de que el coche se está saliendo de su carril, ninguno de estos sensores hace mucho por alterar la interacción del conductor con el vehículo.

Las alertas de voz ofrecen una forma mucho más flexible para que la IA ayude al conductor. Algunos estudios recientes han demostrado que los mensajes hablados son la mejor manera de transmitir de qué se trata la alerta y son la opción preferible en situaciones de conducción de baja urgencia. Y, de hecho, la industria automotriz está comenzando a adoptar tecnología que funciona como un asistente virtual. De hecho, algunos fabricantes de automóviles han anunciado aviones para introducir agentes conversacionales que ayudan a los conductores a operar sus vehículos y los ayudan a organizar su vida diaria.

La idea de construir un sistema de navegación intuitivo basado en una serie de sensores automotrices surgió en 2012 durante conversaciones con nuestros colegas de la división de negocios automotrices de Mitsubishi Electric en Sanda, Japón. Notamos que cuando está sentado al lado del conductor, no dice: «Gire a la derecha en 20 metros». En su lugar, dirá: «Gira en ese Starbucks en la esquina». También puede advertir al conductor de un carril que está obstruido más adelante o de una bicicleta que está a punto de cruzarse en el camino del automóvil. Y si el conductor malinterpreta lo que dices, continuarás aclarando lo que quisiste decir. Si bien este enfoque para dar instrucciones u orientación es algo natural para las personas, está mucho más allá de las capacidades de los sistemas de navegación para automóviles actuales.

Aunque teníamos muchas ganas de construir una ayuda de navegación para vehículos tan avanzada, muchas de las tecnologías de los componentes, incluidos los aspectos de visión y lenguaje, no estaban lo suficientemente maduras. Así que dejamos la idea en suspenso, esperando revisarla cuando llegara el momento. Habíamos estado investigando muchas de las tecnologías que serían necesarias, incluida la detección y el seguimiento de objetos, la estimación de profundidad, el etiquetado semántico de escenas, la localización basada en la visión y el procesamiento del habla. Y estas tecnologías avanzaban rápidamente, gracias a la revolución del aprendizaje profundo.

Pronto, desarrollamos un sistema que era capaz de ver un video y responder preguntas al respecto. Para comenzar, escribimos un código que podía analizar las funciones de audio y video de algo publicado en YouTube y producir subtítulos automáticos para ello. Una de las ideas clave de este trabajo fue la apreciación de que en algunas partes de un video, el audio puede brindar más información que las características visuales y viceversa en otras partes. Sobre la base de esta investigación, los miembros de nuestro laboratorio organizaron el primer desafío público sobre el diálogo consciente de la escena en 2018, con el objetivo de construir y evaluar sistemas que puedan responder con precisión preguntas sobre una escena de video.

Entonces decidimos que finalmente era hora de revisar el concepto de navegación basada en sensores. Al principio pensamos que las tecnologías de los componentes estaban a la altura, pero pronto nos dimos cuenta de que la capacidad de la IA para el razonamiento detallado sobre una escena aún no era lo suficientemente buena para crear un diálogo significativo.

Una IA fuerte que pueda razonar en general todavía está muy lejos, pero ahora es posible un nivel moderado de razonamiento, siempre que se limite al contexto de una aplicación específica. Queríamos crear un sistema de navegación para automóviles que ayudara al conductor al proporcionar su propia visión de lo que sucede dentro y alrededor del automóvil.

Un desafío que se hizo evidente rápidamente fue cómo lograr que el vehículo determinara su posición con precisión. El GPS a veces no era lo suficientemente bueno, especialmente en los cañones urbanos. No podía decirnos, por ejemplo, exactamente qué tan cerca estaba el automóvil de una intersección y era aún menos probable que proporcionara información precisa sobre el nivel del carril.

Por lo tanto, recurrimos a la misma tecnología de mapeo que admite la conducción autónoma experimental, donde los datos de la cámara y el lidar (radar láser) ayudan a ubicar el vehículo en un mapa tridimensional. Afortunadamente, Mitsubishi Electric tiene un sistema de mapeo móvil que brinda la precisión necesaria a nivel de centímetros, y el laboratorio estaba probando y comercializando esta plataforma en el área de Los Ángeles. Ese programa nos permitió recopilar todos los datos que necesitábamos.

Un objetivo clave era proporcionar orientación basada en puntos de referencia. Sabíamos cómo entrenar modelos de aprendizaje profundo para detectar decenas o cientos de clases de objetos en una escena, pero hacer que los modelos eligieran cuál de esos objetos mencionar, «prominencia de objetos», requería más reflexión. Nos decidimos por un modelo de red neuronal de regresión que consideraba el tipo de objeto, el tamaño, la profundidad y la distancia desde la intersección, la distinción del objeto en relación con otros objetos candidatos y la ruta particular que se estaba considerando en ese momento. Por ejemplo, si el conductor necesita girar a la izquierda, probablemente sería útil referirse a un objeto a la izquierda que sea fácil de reconocer para el conductor. “Sigue el camión rojo que gira a la izquierda”, podría decir el sistema. Si no encuentra ningún objeto destacado, siempre puede ofrecer instrucciones de navegación basadas en la distancia: «Gire a la izquierda en 40 metros».

Sin embargo, queríamos evitar tales conversaciones robóticas tanto como fuera posible. Nuestra solución fue desarrollar una red de aprendizaje automático que grafica la profundidad relativa y las ubicaciones espaciales de todos los objetos en la escena, luego basa el procesamiento del lenguaje en este gráfico de escena. Esta técnica no solo nos permite razonar sobre los objetos en un momento determinado, sino también captar cómo van cambiando con el tiempo.

Dicho análisis dinámico ayuda al sistema a comprender el movimiento de peatones y otros vehículos. Estábamos particularmente interesados en poder determinar si un vehículo adelante estaba siguiendo la ruta deseada, de modo que nuestro sistema pudiera decirle al conductor: «Siga ese automóvil». Para una persona en un vehículo en movimiento, la mayoría de las partes de la escena parecerán estar en movimiento, por lo que necesitábamos una forma de eliminar los objetos estáticos del fondo. Esto es más complicado de lo que parece: simplemente distinguir un vehículo de otro por el color es un desafío en sí mismo, dados los cambios en la iluminación y el clima. Es por eso que esperamos agregar otros atributos además del color, como la marca o el modelo de un vehículo o tal vez un logotipo reconocible, por ejemplo, el de un camión del Servicio Postal de EE. UU.

La generación de lenguaje natural fue la última pieza del rompecabezas. Eventualmente, nuestro sistema podría generar la instrucción o advertencia adecuada en forma de oración usando una estrategia basada en reglas.

La generación de oraciones basada en reglas ya se puede ver de forma simplificada en los juegos de computadora en los que los algoritmos entregan mensajes situacionales basados en lo que hace el jugador. Para la conducción, se puede anticipar una gran variedad de escenarios y, por lo tanto, se puede programar la generación de oraciones basada en reglas de acuerdo con ellos. Por supuesto, es imposible conocer todas las situaciones que puede experimentar un conductor. Para cerrar la brecha, tendremos que mejorar la capacidad del sistema para reaccionar ante situaciones para las que no ha sido programado específicamente, utilizando datos recopilados en tiempo real. Hoy en día esta tarea es muy desafiante. A medida que la tecnología madure, el equilibrio entre los dos tipos de navegación se inclinará más hacia las observaciones basadas en datos.

Por ejemplo, sería reconfortante para el pasajero saber que la razón por la cual el automóvil cambia repentinamente de carril es porque quiere evitar un obstáculo en la carretera o evitar un atasco más adelante bajándose en la próxima salida. Además, esperamos que las interfaces de lenguaje natural sean útiles cuando el vehículo detecta una situación que no ha visto antes, un problema que puede requerir un alto nivel de cognición. Si, por ejemplo, el automóvil se acerca a una carretera bloqueada por una construcción, sin un camino claro a su alrededor, el automóvil podría pedirle consejo al pasajero. Entonces, el pasajero podría decir algo como: «Parece posible girar a la izquierda después del segundo cono de tráfico».

Debido a que la conciencia del vehículo sobre su entorno es transparente para los pasajeros, pueden interpretar y comprender las acciones que realiza el vehículo autónomo. Se ha demostrado que tal comprensión establece un mayor nivel de confianza y seguridad percibida.

Visualizamos este nuevo patrón de interacción entre las personas y sus máquinas como una forma más natural y más humana de gestionar la automatización. De hecho, se ha argumentado que los diálogos dependientes del contexto son la piedra angular de la interacción humano-computadora.

Los automóviles pronto estarán equipados con sistemas de advertencia basados en el idioma que alertarán a los conductores sobre peatones y ciclistas, así como sobre obstáculos inanimados en la carretera. Dentro de tres a cinco años, esta capacidad avanzará a la guía de ruta basada en puntos de referencia y, en última instancia, a asistentes virtuales conscientes de la escena que involucran a los conductores y pasajeros en conversaciones sobre lugares y eventos circundantes. Dichos diálogos pueden hacer referencia a las reseñas de Yelp de restaurantes cercanos o involucrarse en la narración de historias al estilo de un diario de viaje, por ejemplo, cuando se conduce a través de regiones interesantes o históricas.

Los conductores de camiones también pueden obtener ayuda para navegar por un centro de distribución desconocido u obtener asistencia para enganchar. Aplicados en otros dominios, los robots móviles podrían ayudar a los viajeros cansados con su equipaje y guiarlos a sus habitaciones, o limpiar un derrame en el pasillo 9, y los operadores humanos podrían brindar orientación de alto nivel a los drones de entrega cuando se acercan a un lugar de entrega. .

Esta tecnología también va más allá del problema de la movilidad. Los asistentes médicos virtuales pueden detectar la posible aparición de un derrame cerebral o una frecuencia cardíaca elevada, comunicarse con un usuario para confirmar si realmente hay un problema, transmitir un mensaje a los médicos para buscar orientación y, si la emergencia es real, alertar a los primeros en responder. Los electrodomésticos pueden anticipar la intención de un usuario, por ejemplo, apagando el aire acondicionado cuando el usuario sale de casa. Tales capacidades constituirían una conveniencia para la persona típica, pero cambiarían las reglas del juego para las personas con discapacidades.

El procesamiento de voz natural para comunicaciones de máquina a humano ha recorrido un largo camino. Lograr el tipo de interacciones fluidas entre robots y humanos como se muestra en la televisión o en las películas aún puede estar algo lejos. Pero ahora, al menos es visible en el horizonte.